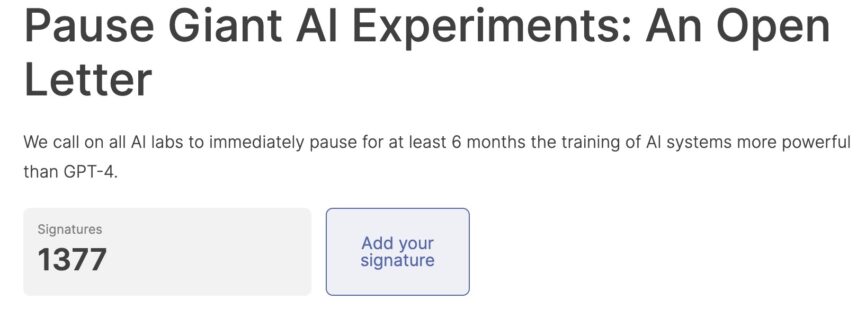

Avec une lettre ouverte publiée par l'association Institut de l'avenir de la vie Elon Musk et un millier d'autres chercheurs ont tiré la sonnette d'alarme sur dangers de l'intelligence artificielle. La phrase qui a le plus d'impact est celle qui pose une question forte à la communauté scientifique : "L'intelligence artificielle présente des risques profonds pour la société et l'humanité et pour cette raison une pause d'au moins six mois serait nécessaire pour la formation des systèmes les plus avancés".

Elon Musk et d'autres universitaires appellent à un arrêt ou à un moratoire sur les gouvernements pour éviter le redoutable 'Scénario Terminator, afin de permettre le développement de protocoles de sécurité partagés.

Le co-fondateur d'Apple a signé la lettre Steve Wozniak mais aussi ceux de Pinterest e Skype, ainsi que les fondateurs de startups d'intelligence artificielle IA de stabilité e Caractères.ai. Plus d'un millier de managers et d'experts du monde entier ont signé la lettre.

Musk ne veut pas diaboliser une technologie nouvelle et émergente aussi parce qu'elle veut améliorer le cerveau intelligent avec Neuralink après avoir conquis l'espace avec SpaceX et l'automobile avec Tesla. Musk a investi massivement financièrement dans des sociétés d'IA liées à Microsoft pour suivre l'avenir plus avancé que tout le monde aspire à être stratégiquement dissuasif et attrayant.

Abonnez-vous à notre newsletter!

Cependant, pour l'instant, les systèmes les plus avancés suscitent des inquiétudes GPT-4, le chatbot OpenAI capable de raconter des blagues et de passer facilement des examens comme celui pour devenir avocat, écrit Ansa.

"Des systèmes d'IA puissants ne devraient être développés que lorsqu'il est certain que leurs effets seront positifs et que leurs risques seront gérables", est souligné dans la lettre. La missive est pragmatique quand elle parle d'un "se précipitent pour développer et déployer de puissants esprits numériques que personne, pas même leurs créateurs, ne peut comprendre, prévoir et contrôler.

La Chine a déjà averti les États-Unis : «l'intelligence artificielle ne devient pas un outil ou une arme pour parfaire la surveillance orwellienne techno-totalitaire" .

L'Intelligence Artificielle pourrait conduire à la destruction du monde en évoquant de nombreux films de science-fiction et pour cette raison, afin d'éviter juste la pensée de conséquences catastrophiques, les grands noms de la haute technologie demandent une pause de six mois à utiliser pour le "développement et mise en œuvre conjoints de protocoles partagés" qui garantissent la "sécurité" des systèmes "au-delà de tout doute raisonnable". La lettre appelle les laboratoires d'IA à se concentrer sur la fabrication de plus "exactes, transparentes, crédibles et justes" les systèmes actuels au lieu de courir vers le développement de moyens encore plus puissants. "L'entreprise a fait une pause sur d'autres technologies aux effets potentiellement catastrophiques – poursuit la lettre -. Nous pouvons le faire dans ce cas aussi. Profitons d'un long été d'IA, et ne nous précipitons pas vers l'automne sans préparation."

Texte intégral de la lettre

Les systèmes d'IA dotés d'une intelligence humaine et compétitive peuvent poser de graves risques pour la société et l'humanité, comme le montrent des recherches approfondies et reconnus par les meilleurs laboratoires d'IA. Comme indiqué dans le document largement approuvé Asilomar AI Principes, L'IA avancée pourrait représenter un changement profond dans l'histoire de la vie sur Terre et devrait être planifiée et gérée avec un soin et des ressources proportionnés. Malheureusement, ce niveau de planification et de gestion ne se produit pas, même si ces derniers mois ont vu les laboratoires d'IA enfermés dans une course effrénée pour développer et déployer des esprits numériques toujours plus puissants que personne - pas même leurs créateurs - ne peut comprendre, prédire ou contrôler de manière fiable.

Les systèmes d'IA contemporains deviennent désormais compétitifs pour les humains dans les tâches générales, et nous devons nous demander : Si laissons-nous les machines inonder nos canaux d'information de propagande et de contrevérité ? Si nous automatisons toutes les tâches, y compris celles qui sont épanouissantes ? Si nous développons des esprits non humains qui pourraient éventuellement être plus nombreux, plus intelligents, obsolètes et nous remplacer ? Si risquons-nous de perdre le contrôle de notre civilisation ? De telles décisions ne doivent pas être déléguées à des leaders technologiques non élus. Des systèmes d'IA puissants ne devraient être développés qu'une fois que nous sommes convaincus que leurs effets seront positifs et que leurs risques seront gérables. Cette confiance doit être bien justifiée et augmenter avec l'ampleur des effets potentiels d'un système. OpenAI déclaration récente concernant l'intelligence artificielle générale, stipule que "À un moment donné, il peut être important d'obtenir un examen indépendant avant de commencer à former de futurs systèmes, et pour les efforts les plus avancés d'accepter de limiter le taux de croissance du calcul utilisé pour créer de nouveaux modèles." Nous sommes d'accord. Ce point est maintenant.

Par conséquent, nous appelons tous les laboratoires d'IA à suspendre immédiatement pendant au moins 6 mois la formation des systèmes d'IA plus puissants que GPT-4. Cette pause doit être publique et vérifiable, et inclure tous les acteurs clés. Si une telle pause ne peut pas être décrétée rapidement, les gouvernements devraient intervenir et instituer un moratoire.

Les laboratoires d'IA et les experts indépendants devraient profiter de cette pause pour développer et mettre en œuvre conjointement un ensemble de protocoles de sécurité partagés pour la conception et le développement avancés d'IA qui sont rigoureusement audités et supervisés par des experts externes indépendants. Ces protocoles devraient garantir que les systèmes qui y adhèrent sont sûrs au-delà de tout doute raisonnable. Cela fait ne sauraient signifient une pause dans le développement de l'IA en général, simplement un recul par rapport à la course dangereuse vers des modèles de boîtes noires imprévisibles toujours plus grands avec des capacités émergentes.

La recherche et le développement de l'IA devraient être recentrés sur la fabrication des systèmes puissants et à la pointe de la technologie d'aujourd'hui plus précis, sûrs, interprétables, transparents, robustes, alignés, dignes de confiance et loyaux.

En parallèle, les développeurs d'IA doivent travailler avec les décideurs politiques pour accélérer considérablement le développement de systèmes de gouvernance de l'IA robustes. Celles-ci devraient au minimum inclure : de nouvelles autorités de réglementation compétentes dédiées à l'IA ; la surveillance et le suivi de systèmes d'IA hautement performants et de vastes pools de capacités de calcul ; des systèmes de provenance et de filigrane pour aider à distinguer le réel du synthétique et à suivre les fuites de modèles ; un solide écosystème d'audit et de certification ; responsabilité pour les dommages causés par l'IA ; un financement public solide pour la recherche technique sur la sécurité de l'IA ; et des institutions bien dotées en ressources pour faire face aux perturbations économiques et politiques dramatiques (en particulier pour la démocratie) que l'IA entraînera.

L'humanité peut profiter d'un avenir florissant avec l'IA. Après avoir réussi à créer de puissants systèmes d'IA, nous pouvons maintenant profiter d'un « été de l'IA » dans lequel nous récoltons les fruits, concevons ces systèmes pour le bénéfice de tous et donnons à la société une chance de s'adapter. La société a fait une pause sur d'autres technologies avec des effets potentiellement catastrophiques sur la société. Nous pouvons le faire ici. Profitons d'un long été d'IA, ne nous précipitons pas sans préparation dans une chute.