Với một bức thư ngỏ được xuất bản bởi tổ chức phi lợi nhuận Viện tương lai của cuộc sống Elon Musk và hàng nghìn nhà nghiên cứu khác đã gióng lên hồi chuông cảnh báo về sự nguy hiểm của trí tuệ nhân tạo. Câu có tác động lớn nhất là câu đặt ra câu hỏi mạnh mẽ cho cộng đồng khoa học: "Trí tuệ nhân tạo đặt ra những rủi ro sâu sắc cho xã hội và nhân loại và vì lý do này, cần có thời gian nghỉ ít nhất sáu tháng để đào tạo các hệ thống tiên tiến nhất".

Elon Musk và các học giả khác đang kêu gọi dừng hoặc tạm dừng các chính phủ để tránh 'sự khủng khiếp'kịch bản kẻ hủy diệt, để cho phép phát triển các giao thức bảo mật được chia sẻ.

Đồng sáng lập Apple đã ký vào bức thư Steve Wozniak nhưng cũng là của Pinterest e Skype, cũng như những người sáng lập công ty khởi nghiệp trí tuệ nhân tạo AI ổn định e Nhân vật.ai. Hơn một nghìn nhà quản lý và chuyên gia trên toàn thế giới đã ký vào bức thư.

Musk không muốn quỷ hóa một công nghệ mới và nổi lên cũng vì muốn cải thiện bộ não thông minh với Neuralink sau khi đã chinh phục không gian với SpaceX và ô tô với Tesla. Musk đã đầu tư tài chính rất nhiều vào các công ty AI có liên quan đến Microsoft để bắt kịp với tương lai tiên tiến hơn mà mọi người đều mong muốn trở thành chiến lược răn đe và hấp dẫn.

Theo dõi bản tin của chúng tôi!

Tuy nhiên, hiện tại, các hệ thống tiên tiến nhất đang gây lo ngại GPT-4, chatbot OpenAI có khả năng kể chuyện cười và dễ dàng vượt qua các kỳ thi chẳng hạn như kỳ thi trở thành luật sư, Ansa viết.

“Chỉ nên phát triển các hệ thống AI mạnh mẽ khi có niềm tin chắc chắn rằng tác động của chúng sẽ tích cực và rủi ro có thể kiểm soát được”, được nhấn mạnh trong thư. Tên lửa là thực dụng khi nó nói về một "vội vàng chạy trốn để phát triển và triển khai những bộ óc kỹ thuật số mạnh mẽ mà không ai, kể cả những người tạo ra chúng, có thể hiểu, dự đoán và kiểm soát.

Trung Quốc đã cảnh báo Mỹ: “trí tuệ nhân tạo không trở thành một công cụ hay vũ khí để hoàn thiện sự giám sát theo kiểu Orwell theo chủ nghĩa kỹ thuật toàn trị".

Trí tuệ nhân tạo có thể dẫn đến sự hủy diệt của thế giới bằng cách gợi lên nhiều bộ phim khoa học viễn tưởng và vì lý do này, để tránh chỉ nghĩ đến những hậu quả thảm khốc, các tên tuổi lớn trong lĩnh vực công nghệ cao đang xin nghỉ XNUMX tháng để sử dụng cho các "cùng phát triển và triển khai các giao thức dùng chung" để đảm bảo "an ninh" của các hệ thống "vượt quá mọi nghi ngờ hợp lý". Bức thư kêu gọi các phòng thí nghiệm AI tập trung vào việc tạo ra nhiều “chính xác, minh bạch, đáng tin cậy và công bằng" các hệ thống hiện tại thay vì chạy theo hướng phát triển của các phương tiện thậm chí còn mạnh mẽ hơn. “Công ty đã tạm dừng các công nghệ khác có khả năng gây hậu quả thảm khốc – tiếp tục thư -. Chúng tôi cũng có thể làm điều đó trong trường hợp này. Hãy tận hưởng một mùa hè dài của AI và đừng vội bước vào mùa thu khi chưa chuẩn bị."

Toàn văn bức thư

Các hệ thống AI có trí thông minh cạnh tranh với con người có thể gây ra những rủi ro sâu sắc cho xã hội và nhân loại, điều này đã được thể hiện qua nghiên cứu sâu rộng và được các phòng thí nghiệm AI hàng đầu thừa nhận. Như đã nêu trong phần xác nhận rộng rãi Nguyên tắc AI của Asilomar, AI tiên tiến có thể đại diện cho một sự thay đổi sâu sắc trong lịch sử sự sống trên Trái đất và cần được lên kế hoạch cũng như quản lý với sự quan tâm và nguồn lực tương xứng. Thật không may, mức độ lập kế hoạch và quản lý này không xảy ra, mặc dù những tháng gần đây đã chứng kiến các phòng thí nghiệm AI bị cuốn vào một cuộc chạy đua mất kiểm soát nhằm phát triển và triển khai những bộ óc kỹ thuật số mạnh mẽ hơn bao giờ hết mà không ai – kể cả những người tạo ra chúng – có thể hiểu được. dự đoán hoặc kiểm soát một cách đáng tin cậy.

Các hệ thống AI đương đại hiện đang trở nên cạnh tranh với con người trong các nhiệm vụ chung và chúng ta phải tự hỏi: Nếu chúng ta để máy móc tràn ngập các kênh thông tin của chúng ta với tuyên truyền và sai sự thật? Nếu chúng tôi tự động hóa tất cả các công việc, bao gồm cả những công việc hoàn thành? Nếu chúng ta phát triển những bộ óc phi nhân loại mà cuối cùng có thể đông hơn, thông minh hơn, lỗi thời và thay thế chúng ta? Nếu chúng ta có nguy cơ mất kiểm soát nền văn minh của chúng ta? Những quyết định như vậy không được giao cho các nhà lãnh đạo công nghệ không được bầu chọn. Các hệ thống AI mạnh mẽ chỉ nên được phát triển khi chúng ta tin tưởng rằng tác động của chúng sẽ tích cực và rủi ro của chúng sẽ có thể kiểm soát được. Sự tự tin này phải được chứng minh rõ ràng và tăng theo mức độ ảnh hưởng tiềm ẩn của hệ thống. OpenAI tuyên bố gần đây liên quan đến trí tuệ nhân tạo nói chung, tình trạng “Tại một số điểm, điều quan trọng là phải được đánh giá độc lập trước khi bắt đầu đào tạo các hệ thống trong tương lai và để có những nỗ lực tiên tiến nhất nhằm đồng ý hạn chế tốc độ tăng trưởng của điện toán được sử dụng để tạo các mô hình mới.” Chúng ta đồng ý. Đó là điểm bây giờ.

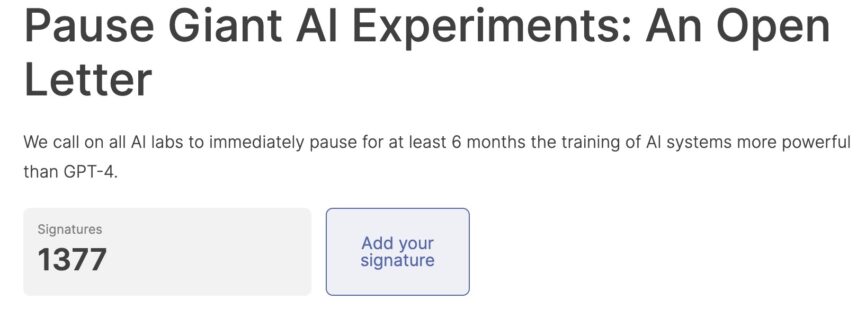

Vì vậy, chúng tôi kêu gọi tất cả các phòng thí nghiệm AI ngay lập tức tạm dừng ít nhất 6 tháng việc đào tạo các hệ thống AI mạnh hơn GPT-4. Việc tạm dừng này phải được công khai và có thể kiểm chứng, đồng thời bao gồm tất cả các tác nhân chính. Nếu việc tạm dừng như vậy không thể được ban hành nhanh chóng, các chính phủ nên can thiệp và đưa ra lệnh cấm.

Các phòng thí nghiệm AI và các chuyên gia độc lập nên sử dụng thời gian tạm dừng này để cùng phát triển và triển khai một bộ giao thức an toàn dùng chung cho thiết kế và phát triển AI tiên tiến, được kiểm tra và giám sát nghiêm ngặt bởi các chuyên gia độc lập bên ngoài. Các giao thức này phải đảm bảo rằng các hệ thống tuân theo chúng được an toàn ngoài sự nghi ngờ hợp lý. Điều này không không có nghĩa là tạm dừng phát triển AI nói chung, chỉ đơn thuần là một bước lùi khỏi cuộc đua nguy hiểm để chuyển sang các mô hình hộp đen không thể đoán trước lớn hơn bao giờ hết với các khả năng mới nổi.

Việc nghiên cứu và phát triển AI nên được tái tập trung vào việc làm cho các hệ thống mạnh mẽ, hiện đại ngày nay trở nên chính xác, an toàn, dễ hiểu, minh bạch, mạnh mẽ, phù hợp, đáng tin cậy và trung thành.

Song song đó, các nhà phát triển AI phải làm việc với các nhà hoạch định chính sách để tăng tốc đáng kể sự phát triển của các hệ thống quản trị AI mạnh mẽ. Những điều này ở mức tối thiểu phải bao gồm: các cơ quan quản lý mới và có năng lực dành riêng cho AI; giám sát và theo dõi các hệ thống AI có khả năng cao và các nhóm khả năng tính toán lớn; hệ thống đánh dấu nguồn gốc và hình mờ để giúp phân biệt thật với tổng hợp và theo dõi rò rỉ mô hình; một hệ sinh thái kiểm toán và chứng nhận mạnh mẽ; trách nhiệm đối với tổn hại do AI gây ra; tài trợ công mạnh mẽ cho nghiên cứu an toàn AI kỹ thuật; và các tổ chức có nguồn lực tốt để đối phó với những gián đoạn nghiêm trọng về kinh tế và chính trị (đặc biệt là đối với nền dân chủ) mà AI sẽ gây ra.

Nhân loại có thể tận hưởng một tương lai hưng thịnh với AI. Sau khi đã thành công trong việc tạo ra các hệ thống AI mạnh mẽ, giờ đây chúng ta có thể tận hưởng “mùa hè AI”, trong đó chúng ta gặt hái thành quả, thiết kế các hệ thống này vì lợi ích rõ ràng của tất cả mọi người và cho xã hội cơ hội thích nghi. Xã hội đã tạm dừng các công nghệ khác có khả năng gây hậu quả thảm khốc cho xã hội. Chúng ta có thể làm như vậy ở đây. Hãy tận hưởng một mùa hè AI dài, đừng vội vàng chuẩn bị cho một mùa thu.